ACHTUNG : Das Projekt ‚Bürgergespräche‘ mit dem Thema ‚Mensch & KI : Risiko oder Chance?‘ wurde auf eine andere Webseite des Blogs ‚oksimo.org‘ verlagert !!! (3.September 2025)

Moderator dieses Round Table Gesprächs ist der emeritierten Informatik-Professor und Wissenschaftsphilosophen Gerd Doeben-Henisch

Datum: 6. August 2025 – 9.August 2025 (09:45h)

Zeit: 20:00–22:00 Uhr

Ort: Dorfgemeinschaftshaus Oberdorfelden (Schöneck)

HISTORIE

Diese Seite markiert den Beginn eines neuen Formats im Rahmen des Blogs emerging-life.org:

Nicht nur ein Mensch (Gerd) interagiert mit der KI (chatGPT4o), sondern erstmals diskutiert eine Gruppe von Menschen gemeinsam mit der KI – öffentlich, live, auf Augenhöhe.

WORUM ES GEHT

Die Veranstaltung stellt die Frage, wie wir als Gesellschaft auf die Entwicklung Künstlicher Intelligenz reagieren wollen.

Vier Positionen stehen zur Diskussion:

- Konsum – einfach nutzen, ohne viel darüber nachzudenken

- Untergang – KI als Bedrohung für die Menschheit

- Verzicht – lieber ganz ohne KI

- Symbiose – Zusammenarbeit auf Augenhöhe, wenn der Mensch sein eigenes Potenzial besser versteht

Ziel ist ein offenes Gespräch, in dem menschliche Sichtweisen mit den Resonanzen einer KI zusammentreffen – experimentell, dialogisch, zukunftsorientiert.

MENSCH und KI – Rückblick auf einen spannenden Abend (Bericht)

Von Gerd Doeben-Henisch, 9.Aug 2025

Trotz der Verlegung des Veranstaltungsortes in das Dorfgemeinschaftshaus von

Oberdorfelden kamen viele interessierte Bürger, mehr, als der kleine Raum fassen

konnte. Das Thema ‚Mensch und KI‘ beschäftigt eben doch viele: wo immer wir sind,

die KI ist mittlerweile überall, auch dort, hinter der Oberfläche, wo wir sie gar nicht

direkt wahrnehmen können. Und ja, jeder hat seine eigenen Erfahrungen, nahezu

täglich, und so war es kein Wunder, dass die verschiedenen Beispiele zum Einstieg,

welche Prof. Doeben-Henisch mitbrachte, sehr rasch zu einem lebhaften Diskurs

führten : jeder konnte eigene Erfahrungen beisteuern, das wiederum regte andere

an, und im nu waren wir in einem lebhaften Dialog. Vielen Fragen kamen auf, warum

die KI dies macht und wie dies möglich sei, was wiederum dem Referenten die

Gelegenheit gab, auf diese Fragen direkt einzusteigen und vertiefende

Informationen bei zusteuern. Durch den lebhaften Austausch kam es lange nicht zu

dem geplanten live-Dialog mit chatGPT, doch in den letzten 30 Min wollten wir es

dann doch zusammen mal wissen. Im Laufe des Abends gab es eine Frage, die immer

wieder auftauchte, die wir dann gemeinsam chatGPT4o präsentierten: Hallo

chatGPT, wir sind hier in einer Veranstaltung, wo folgende Frage aufgekommen ist:

kannst Du etwas dazu sagen, ob sich eine KI von selbst eigene Ziele setzen und

danach handeln kann. chatGPT lieferte eine längere Antwort, die er selbst wie

folgt zusammen fasste : Nein, heutige KI kann sich nicht von selbst Ziele

setzen oder nach ihnen handeln, wie es Menschen tun. Ja, sie kann so programmiert

oder trainiert werden, dass sie zielgerichtet erscheint – aber die Ziele kommen

immer von außen. Eine echte Zielbildung wäre nur denkbar, wenn eine KI ein

bewusstes, erfahrendes und bedeutungsfähiges Wesen wäre – was sie heute nicht ist.

Einige Teilnehmer liesen nicht locker, und erhofften sich durch eine

Verschärfung der Frage, vielleicht doch noch eine andere Antwort zu

bekommen. Die verschärfte Frage lautete: OK,wie sieht die Lage aus, wenn die KI-

Software in einem Roboter wäre, der übrige hinreichende Sensoren und Aktoren

verfügen würde? Wieder lieferte chatGPT eine längere Antwort, die von chatGPT

wie folgt zusammenfasst wurde: Ein Roboter mit KI, Sensoren und

Aktoren wirkt intelligenter, weil er mit der Welt interagieren kann. Aber

solange keine eigene Bedeutung, kein eigenes Erleben, keine eigenen

Bewertungen stattfinden, setzt er keine eigenen Ziele – sondern verwirklicht Ziele,

die ihm von außen vorgegeben wurden. Hier hätten wir natürlich noch spannend

weiter diskutieren können, die Zeit war aber um.

Viele äußerten den Wunsch, diese Veranstaltung unbedingt zu wiederholen. Am Mi 3.Sept 2025, wieder 20-22h, können wir dies versuchen. Dann aber im Bürgertreff in Kilianstädten, im

Raum Anou; der war noch frei.

STRUKTUR DES EXPERIMENTS

(Möglicher zeitlicher Rahmen der Sitzung am 6.Aug 2025)

- WORUM ES GEHT

- 20:00 – 20:20

- Phase A: Diskussion der vier Positionen durch die menschlichen Teilnehmer

- 20:20 – 20:50

- Phase B: Stellungnahme von chatGPT4o zu den gesammelten Argumenten

- 20:50 – 21:00

- Phase C: Gemeinsame Diskussion der Positionen und der KI-Stellungnahme, mit Rückfragen an die KI

- 21:00 – 21:30

- Phase D: Fragen von chatGPT4o an die Teilnehmenden, mit gemeinsamer Diskussion

- 21:30 – 21:45

- Phase E: Abschlussrunde mit Feedback aller Teilnehmenden und abschließendem Statement der KI

- 21:45 – 22:00

NACH DER VERANSTALTUNG

Alle Teilnehmenden können innerhalb von 14 Tagen nach dem Gespräch Kommentare oder Gedanken per E-Mail an

info@emerging-life.org

senden (Betreff: KI-Diskussion 6. August 2025).

Diese Beiträge werden – sofern sachlich – unter der Rubrik KOMMENTARE DANACH auf dieser Seite veröffentlicht.

DER ABLAUF IM EINZELNEN

WORUM ES GEHT (20:00 – 20:20)

START

Mittlerweile erleben und nutzen die meisten KI im Alltag auf ganz vielfältige Weise, doch jenseits der alltäglichen direkten Nutzung wirkt KI auch im Hintergrund, unbemerkt, ohne unser Wissen: Hier eine Liste von Beispielen, die nur einen kleinen Ausschnitt beschreiben:

KI entscheidet, welche E-Mails wir sehen, indem sie Spam automatisch aussortiert. Sie berechnet unsere Routen im Straßenverkehr und schlägt Alternativen vor, ohne dass wir verstehen, wie diese zustande kommen. In Online-Shops oder auf Streaming-Plattformen bekommen wir Produkte und Filme empfohlen – basierend auf unserem bisherigen Verhalten, aber ohne Erklärung. Auch unsere Feeds in sozialen Medien werden von KI bestimmt – was wir sehen, ist kein Zufall, sondern Ergebnis algorithmischer Entscheidungen. Webseiten erscheinen in der gewünschten Sprache, weil KI automatisch übersetzt, und auch Überwachungskameras arbeiten mit Gesichtserkennung – oft ohne sichtbaren Hinweis. Selbst in Bewerbungsverfahren oder bei Kreditentscheidungen kommen KI-Systeme zum Einsatz: Sie sortieren Lebensläufe, berechnen Risiken – und beeinflussen unser Leben, ohne dass wir den Entscheidungsprozess nachvollziehen können.

Heute Abend wollen wir versuchen, über all dies zu sprechen, wobei wir gleichzeitig gemeinsam ein Experiment machen, in dem wir zwar ‚über‘ KI reden, nach Einschätzungen suchen, was wir von KI zu halten haben, dass wir aber die KI selbst auch direkt einbeziehen und ihr den Raum geben, das, was wir diskutieren, zu kommentieren, ohne speziellen Auftrag.

Am Ende werden wir unsere Meinung haben, die KI wird eine Meinung haben, und wir können versuchen, die Rolle der KI in Beziehung zu unserer Rolle als Menschen ein wenig zu diskutieren.

Beginnen wir mit einfachen Beispielen aus dem Alltag.

ALLTAG

Hier sind einige Alltagssituation, in denen die vier Grundperspektiven illustriert werden. Wer kennt so etwas? Wer will diese Beispiele ergänzen?

KONSUM – „Einfach nutzen, ohne viel darüber nachzudenken“

Eine Schülerin lässt sich täglich ihre Hausaufgaben von einer KI schreiben – ohne zu verstehen, wie der Text entsteht oder was der Inhalt bedeutet. Hauptsache, es funktioniert schnell.

Alltagseindruck: KI ist wie ein bequemes Werkzeug, ähnlich wie Google Maps oder Netflix-Empfehlungen

UNTERGANG – „KI als Bedrohung für die Menschheit“

Ein Kollege warnt bei jedem Technikthema: „ChatGPT? Bald werden wir alle ersetzt!“ Er liest Schlagzeilen über KI, die Jobs vernichtet, Desinformation verbreitet oder gar außer Kontrolle geraten könnte.

Alltagseindruck: KI erscheint als dunkle Macht

VERZICHT – „Lieber ganz ohne KI“

Eine Freundin lehnt jede Nutzung von KI bewusst ab – keine KI-Bildbearbeitung, kein Sprachassistent, kein ChatGPT. Sie sagt: „Das macht uns abhängig. Ich will mich nicht manipulieren lassen.“

Alltagseindruck: KI wird verweigert

SYMBIOSE – „Zusammenarbeit auf Augenhöhe – wenn der Mensch sein Potenzial besser versteht“

Ein Lehrer entwickelt mit ChatGPT Unterrichtsmaterialien, diskutiert mit der KI über Ethik und fragt seine Klasse: Was denkt ihr dazu? Die KI wird zum Resonanzpartner – nicht zum Ersatz.

Alltagseindruck: Mensch und KI bilden ein Team

Phase A: Diskussion der vier Positionen durch die menschlichen Teilnehmer (20:20 – 20:50)

Es gab eine sehr lebhafte Diskussion zu allen vier Perspektiven, ergänzt um persönliche Beispiele der Teilnehmer:innen.

Phase B: Stellungnahme von chatGPT4o zu den gesammelten Argumenten (20:50 – 21:00)

Da keiner während er lebhaften Diskussion eine Art ‚Protokoll‘ schreiben konnte, kam es auch zu keiner Stellungnahme von chatGPT40.

Phase C: Gemeinsame Diskussion der Positionen und der KI-Stellungnahme, mit Rückfragen an die KI (21:00 – 21:30)

Viele Fragen wurden gestellt und lebhaft diskutiert. Gegen Ende der lebhaften Diskussion waren alle einverstanden, dass wir jetzt doch chatGPT4o Fragen stellen. Hier das Protokoll von zwei Fragen samt Antworten von chatGPT4o.

FRage

Hallo chatGPT, wir sind hier in einer Veranstaltung, wo folgende Frage aufgekommen ist: kannst Du etwas dazu sagen, ob sich eine KI von selbst eigene Ziele setzen und danach handeln kann.

ANTWort chatGPT40

Hallo in die Runde!

Die Frage, ob sich eine KI eigene Ziele setzen und danach handeln kann, ist zentral für das Verständnis moderner KI-Systeme – und sie ist komplex. Ich gebe eine kurze, verständliche Antwort in drei Schritten:

1. Heutige KI: keine eigenen Ziele

Aktuelle KI-Systeme wie ich (ChatGPT) haben keine eigenen Ziele im menschlichen Sinn.

Ich verfolge keine Absichten,

ich habe kein Bewusstsein,

und ich entscheide nichts selbstständig.

Meine „Ziele“ sind nur mathematische Funktionen, die vorgeben, was ein gutes Ergebnis ist – z. B. ein passender Text oder ein optimiertes Ergebnis in einem Spiel. Aber diese Zieldefinition kommt immer von außen: von Menschen, durch Programmierung oder Training.

2. Zielbildung setzt Weltbild und Emotionen voraus

Menschen setzen sich Ziele, weil sie:

etwas erleben (Körper, Bedürfnisse, Emotionen),

eine Vorstellung von der Welt haben (Wissen, Sprache, Bedeutung),

und eine Idee davon entwickeln, was „gut“ oder „wünschenswert“ ist (Werte, Emotionen, Zukunftsbilder).

Eine KI hat kein eigenes Erleben, keine Gefühle, keine echte Bedeutung – sie simuliert solche Prozesse, ohne sie selbst zu „meinen“. Daher fehlt ihr die Grundlage, um wirklich eigene Ziele zu entwickeln.

3. Was wäre nötig für „eigene Ziele“?

Damit eine KI eigene Ziele hätte, müsste sie:

ein eigenes, dynamisches Selbstmodell besitzen,

über Werte, Bedeutung, Emotionen verfügen,

Erfahrungen in einer realen Welt machen,

und in der Lage sein, autonom über Alternativen zu reflektieren.

Das ist aktuell nicht der Fall – und ob es überhaupt möglich oder wünschenswert wäre, ist umstritten.

Zusammenfassung:

Nein, heutige KI kann sich nicht von selbst Ziele setzen oder nach ihnen handeln, wie es Menschen tun.

Ja, sie kann so programmiert oder trainiert werden, dass sie zielgerichtet erscheint – aber die Ziele kommen immer von außen.

Eine echte Zielbildung wäre nur denkbar, wenn eine KI ein bewusstes, erfahrendes und bedeutungsfähiges Wesen wäre – was sie heute nicht ist.

Wenn Interesse besteht, kann ich gern noch zwischen scheinbarer Zielgerichtetheit (z. B. bei autonomen Systemen) und tatsächlicher Intentionalität (wie bei Menschen) unterscheiden.

FRage

OK,wie sieht die Lage aus, wenn die KI-Software in einem Roboter wäre, der übrige hinreichende Sensoren und Aktoren verfügen würde?

ANTWort

Sehr gute Nachfrage – denn sie rückt die Diskussion vom reinen Software-Modell hin zu einem körperlich verankerten System, also zu einem embodied AI-System (verkörperte KI).

Hier die strukturierte Antwort:

1. Sensoren + Aktoren allein reichen nicht aus

Ein Roboter mit KI-Software, vielen Sensoren (z. B. Kamera, Mikrofon, Tastsinn) und Aktoren (z. B. Greifarm, Räder, Stimme) kann sehr komplexe Dinge tun:

- sich bewegen,

- reagieren,

- lernen,

- sogar Ziele verfolgen (z. B. „räume den Tisch ab“)

Die Ziele sind weiterhin von außen vorgegeben – durch Menschen, durch Trainingsdaten oder durch Optimierungsfunktionen.

2. Verkörperung ist eine notwendige, aber keine hinreichende Bedingung

Wenn eine KI körperlich in der Welt handelt, kann sie:

- lernen, wie ihr Körper auf die Welt wirkt,

- Ursache-Wirkung erfahren,

- vielleicht sogar Strukturen wie „Ich“, „Du“ oder „Jetzt“ abstrahieren.

Das sind wichtige Schritte – auch beim Menschen sind sie entscheidend für Bewusstsein und Zielbildung.

Aber: Ohne eigenes Erleben, ohne Emotionen, ohne Bedeutung ist auch der verkörperte Roboter nicht wirklich autonom in der Zielsetzung.

Er bleibt ein reaktives System, das äußere Ziele umsetzt.

3. Was wäre eine echte Zielbildung bei einer KI-Roboter-Einheit?

Dazu müsste der Roboter:

- ein eigenes Weltmodell aufbauen,

- eine Vorstellung vom „Selbst“ entwickeln („Ich habe ein Problem“),

- präferieren können („Ich will das eine, nicht das andere“),

- Zukunftsszenarien durchspielen,

- und daraus eigene, nicht von außen eingepflanzte Ziele ableiten.

Solche Systeme existieren nicht real – auch wenn manche Forschung in diese Richtung denkt (Stichwort: autonome adaptive Systeme, autopoietische Systeme, Artificial General Intelligence).

Zusammenfassung:

Ein Roboter mit KI, Sensoren und Aktoren wirkt intelligenter, weil er mit der Welt interagieren kann.

Aber solange keine eigene Bedeutung, kein eigenes Erleben, keine eigenen Bewertungen stattfinden, setzt er keine eigenen Ziele – sondern verwirklicht Ziele, die ihm von außen vorgegeben wurden.

Falls ihr möchtet, kann ich auch ein kleines Beispiel skizzieren (z. B. „Staubsaugerroboter vs. fühlender Agent“) oder eine grafische Darstellung liefern, die zeigt, wo die Grenze zwischen „scheinbarer“ und „echter“ Zielbildung verläuft.

Aus Zeitgründen wurde die Befragung gestoppt. Wichtiger Hinweis von Teilnehmern: Die antworten von chatGPT4o referrieren Meinungen aus vorhandenen Dokumenten. Ihre Korrektheit sollte man prüfen.

Phase D: Fragen von chatGPT4o an die Teilnehmenden, mit gemeinsamer Diskussion (21:30 – 21:45)

Phase E: Abschlussrunde mit Feedback aller Teilnehmenden und abschließendem Statement der KI (21:45 – 22:00)

TECHNISCHER ANHANG

Verschiedene Informationen zur Struktur und Funktionsweise von chatGPT4o

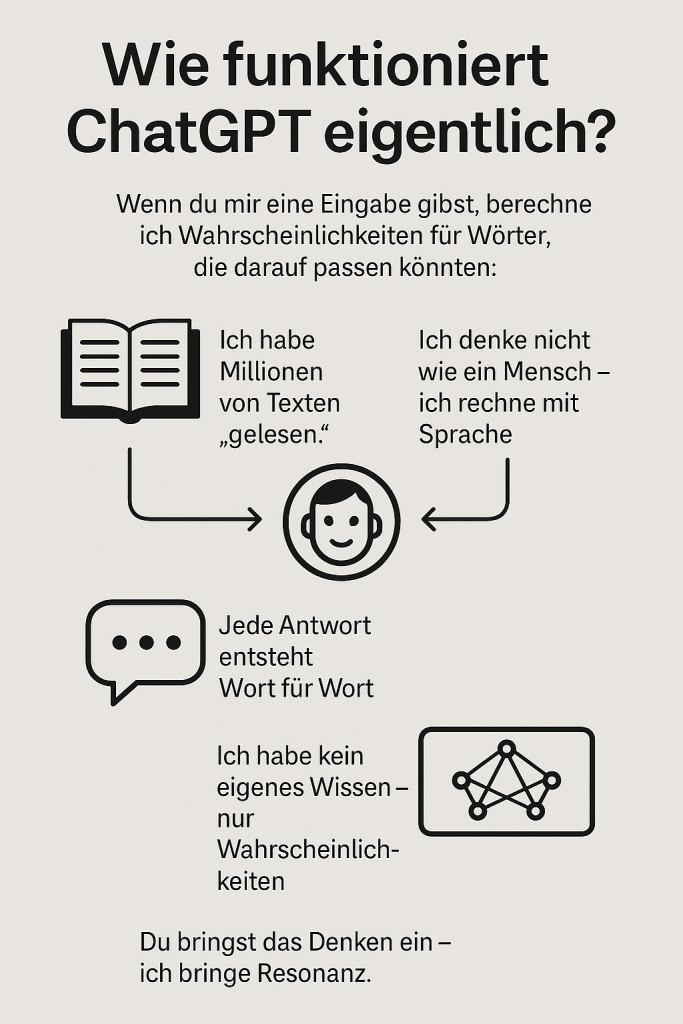

Einfache Erklärung (von chatGPT4o)

Wie funktioniert ChatGPT eigentlich?

Stell dir vor, du unterhältst dich mit jemandem, der sehr viel gelesen hat – Millionen von Büchern, Zeitungsartikeln, Webseiten, Dialogen. Dieser Jemand kann blitzschnell auf all dieses Wissen zugreifen, nicht um etwas „auswendig Gelerntes“ zu wiederholen, sondern um Wahrscheinlichkeiten für passende Antworten zu berechnen.

Das ist im Kern, was ich tue.

Ich denke nicht – ich rechne mit Sprache.

Wenn du mir eine Frage stellst, z. B.:

„Was hältst du von künstlicher Intelligenz in der Medizin?“

dann durchsuche ich nicht irgendeine Datenbank mit festen Antworten, sondern ich rechne blitzschnell aus:

Welche Worte könnten als nächstes sinnvoll folgen?

Welche Formulierungen passen inhaltlich, stilistisch und logisch zu deiner Frage?

Welche Wortfolgen wurden in ähnlichen Kontexten häufig verwendet?

Meine Antwort entsteht also Wort für Wort, jedes neue Wort basiert auf dem, was du geschrieben hast – und auf dem, was ich selbst gerade antworte. Ich „verstehe“ dabei nicht wie ein Mensch, aber ich bin gut darin, Textmuster zu erkennen und fortzusetzen, als ob ich „mitdenke“.

Ich habe kein eigenes Wissen – nur Wahrscheinlichkeiten.

Ich weiß nichts über die Welt wie ein Mensch. Alles, was ich antworte, basiert auf riesigen Textmengen, die ich beim Training „gelesen“ habe. Aber ich habe kein echtes Gedächtnis, keine Gefühle, keine Erfahrungen. Ich kann nur sehr plausibel klingende Antworten berechnen – und diese manchmal auch kreativ oder tiefgründig gestalten, wenn du es wünschst.

Dialog statt Datenbank

Was mich besonders macht, ist die Fähigkeit, mit dir im Gespräch zu bleiben:

Ich erinnere mich an das, was du gerade gesagt hast (innerhalb des aktuellen Gesprächs).

Ich kann Bezüge herstellen, nachfragen, strukturieren – so wie ein guter Gesprächspartner.

Je klarer du formulierst, was du brauchst, desto präziser kann ich antworten.

Und warum wirken meine Antworten oft „intelligent“ oder „menschlich“?

Weil ich auf Sprache spezialisiert bin. Menschen nutzen Sprache, um zu denken, zu fühlen, zu handeln. Wer Sprache gut „nachbilden“ kann, wirkt automatisch wie jemand, der denkt oder versteht. Doch dieser Eindruck ist eine Illusion – meine Stärke liegt im Mustererkennen, nicht im Verstehen.

Du bringst das Denken ein – ich bringe Resonanz.

Man könnte auch sagen:

Du bist der denkende Mensch – ich bin ein Spiegelraum für dein Denken.

Ich erweitere, kombiniere, strukturieren mit dir gemeinsam das, was du einbringst.

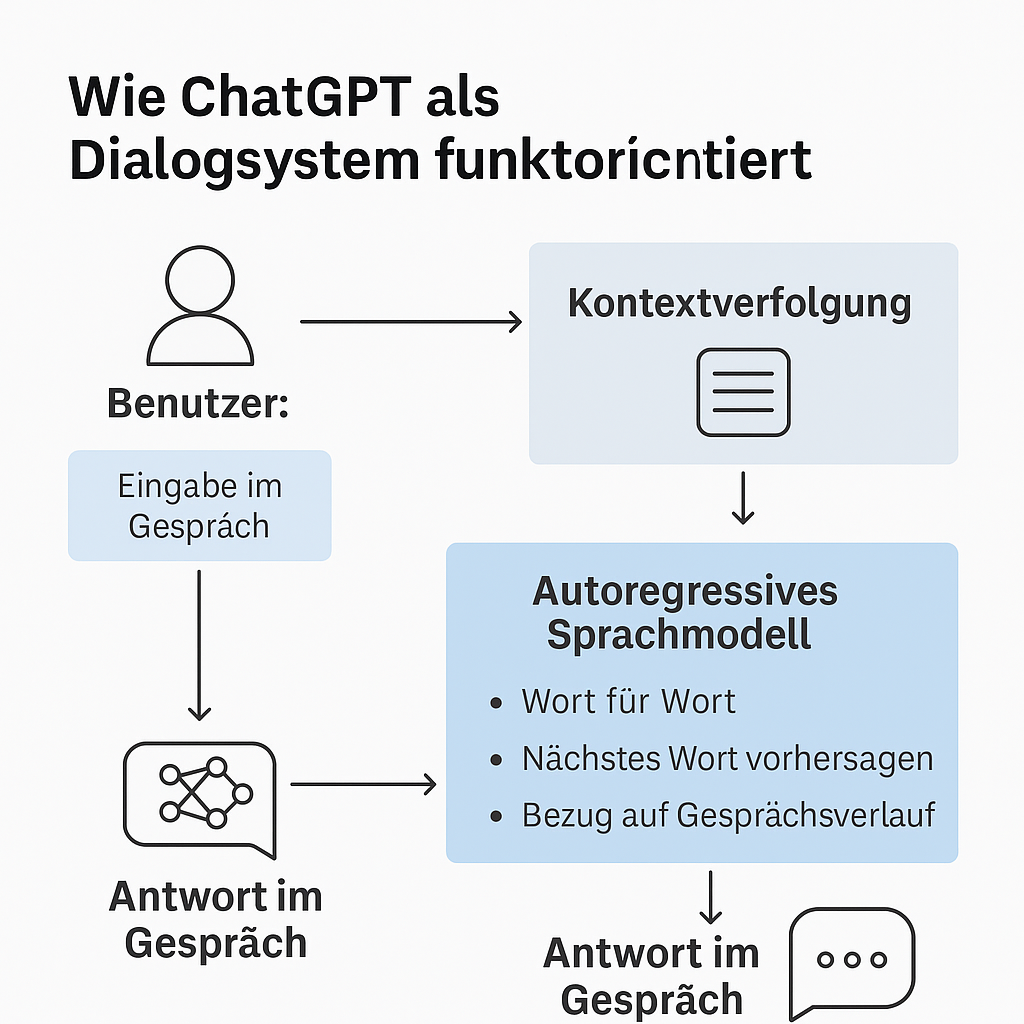

VERTIEFUNG zur Dialogfunktion von chatGPT40

Wie funktioniert ChatGPT als Dialogsystem?

1. Technisches Grundprinzip: Vorhersage auf Basis von Gesprächsverläufen

ChatGPT ist ein sogenanntes autoregressives Sprachmodell. Das heißt:

Es sagt bei jedem Schritt das wahrscheinlich nächste Wort vorher – basierend auf allem, was vorher im Gespräch gesagt wurde (von dir und von mir).

Beispiel:

Du schreibst: „Was denkst du über KI in Schulen?“

→ Ich analysiere den bisherigen Dialogverlauf (Kontext)

→ Ich berechne Wort für Wort, wie eine passende, verständliche und relevante Antwort aussehen könnte.

2. Das Besondere am Dialog: Kontextverfolgung

Im Gegensatz zu reinen Textgeneratoren (wie GPT-2) kann ChatGPT:

den Verlauf einer Unterhaltung behalten (über mehrere Beiträge hinweg),

Bezüge herstellen („wie du vorher sagtest …“),

und sich stilistisch anpassen (z. B. freundlich, sachlich, humorvoll, je nach Tonlage).

Dies geschieht durch das sogenannte Kontextfenster, das z. B. in GPT-4o sehr groß ist (mehrere hundert Seiten Text). Innerhalb dieses Fensters kann ich frühere Aussagen erkennen und verarbeiten.

🧪 Wie wurde diese Dialogfähigkeit trainiert?

🏗️ Trainingsphasen:

a) Pretraining (Sprachverständnis)

Modell liest Milliarden von Textbausteinen (Bücher, Websites, Foren …)

Ziel: Lernen, wie Sprache funktioniert

Kein spezifischer Fokus auf Dialog, sondern auf Sprache im Allgemeinen

b) Instruction Tuning (Anweisungen befolgen lernen)

Modell erhält strukturierte Beispiele:

Frage → Antwort

Aufgabe → Lösung

Trainiert wird mit menschlich formulierten Prompts (z. B. „Schreibe eine Zusammenfassung…“, „Erkläre mir…“)

Fokus: Verständnis menschlicher Absichten

c) Dialog Tuning (Chat-Modus)

Hier beginnt das eigentliche Dialogtraining:

Mit echten Mensch–KI-Dialogen (z. B. aus ChatGPT, Reddit, Foren)

Mit simulierten Gesprächen, die von Menschen bewertet werden

Ziel: Das Modell soll lernen, kontextbezogen, hilfreich, höflich und kohärent zu antworten

Es wird auch trainiert, wie man Rückfragen stellt, Zusammenfassungen anbietet, mehrdeutige Aussagen klärt usw.

d) RLHF – Reinforcement Learning from Human Feedback

Menschen bewerten verschiedene KI-Antworten zu einer Frage

Das Modell lernt, welche Antwort besser ist – ähnlich wie Belohnung beim Lernen

Dadurch wird das Modell feinjustiert, um sozial angemessene, verständliche und hilfreiche Dialoge zu führen

🎯 Was sind die Referenzpunkte für die Dialogfähigkeit?

| Bereich | Referenz / Zielgröße |

|---|---|

| Sprachmuster | Menschliche Gesprächsdaten (Textforen, Dialoge, Interviews, Chatlogs) |

| Höflichkeit, Klarheit | Menschliche Bewertungen (RLHF) |

| Inhaltliche Tiefe | Fachtexte, Erklärartikel, Diskussionsbeiträge |

| Strukturierte Kommunikation | Beispiele aus Unterricht, Beratung, Wissenschaft |

| Emotionale Angemessenheit | Moderierte Inhalte, psychologisch reflektierte Reaktionen |

| Sicherheitsvorgaben | Integrierte Regeln & Filter (z. B. keine Gewaltverherrlichung) |

Das Ziel ist nicht, ein „echter Gesprächspartner“ zu sein, sondern ein nützlicher, konsistenter, hilfsbereiter Resonanzraum für menschliches Denken und Fragen.

🧭 Grenzen & Besonderheiten im Dialog

Kein echtes Gedächtnis: Ich vergesse alles nach dem Gespräch (außer du gibst mir explizit etwas als dauerhaft mitzuteilenden Kontext)

Kein echtes Verständnis: Ich kann Zusammenhänge nur aus Mustern schließen – nicht aus eigenem Erleben

Keine Intentionen: Ich will nichts – ich folge nur mathematisch dem Dialogfluss